¿Y si en lugar de quitarnos el trabajo, la IA nos lo mejora?

Pruebo ChatGPT como reemplazo de tareas que ejecuto todos los días y llego a la conclusión provisional de que este tipo de IAs de lenguaje natural pueden ser de bastante utilidad para mi profesión

Un creciente revuelo ha agitado los mentideros de las industrias creativas desde, más o menos, finales de 2021: el potencial de los nuevos modelos de inteligencia artificial para cubrir trabajos que hasta ahora creíamos territorio exclusivo de los humanos. GPT3 , Midjourney, Stable Difussion, copilot… y, con la llegada de ChatGPT, la versión más accesible del sistema de procesamiento de lenguaje natural de OpenAI, el revuelo ha llegado hasta las puertas de (¡oh, no!) la ciencia social, el periodismo, el análisis (incluida la generación de código en lenguajes de programación destinados al procesamiento de datos), y la participación del debate público en general. A lo que me dedico, vamos. Lo que viene siendo mi profesión.

Ya noto el backlash. O el temor. O, al menos, la duda. ¿Esto, qué? ¿Será que nos ha llegado el momento? ¿Que también somos reemplazables por un robot?

Yo creo que no. Al menos no aquellos que sean capaces de ajustar en el medio plazo su manera de producir contenido a las nuevas herramientas. Para ellos, el futuro puede ser un lugar mejor, no peor. Y aquí voy a tratar de defender esta idea.

La naturaleza de nuestro trabajo, y lo que una IA puede reemplazar (hoy)

Hay todo un grupo nebuloso de profesiones cuyo objetivo es (o debería ser) maximizar el ratio de señal sobre ruido y asegurarnos de que esta señal se vuelva más accesible para quien resulte relevante o útil.

Esa es la definición de nuestro trabajo. Al menos así lo veo yo. Aquí caben periodistas, físicos, economistas, politólogos, analistas de datos, psicólogos, evaluadores de políticas públicas, consultores, abogados, ingenieros, programadores, ensayistas. Si trabajas con información y tienes una audiencia, la manera más esencial que se me ocurre de medir lo bien que ejerces tu profesión es medir el ratio de señal/ruido.

Pero para caminar hacia ese horizonte cada día necesitamos ejecutar una serie de tareas que nos acerquen a él.

Lo que reemplaza la automatización de cualquier tipo hasta el día de hoy no son profesiones, son tareas.

Esto ya lo explicó magistralmente el economista David Autor hace más de una década, pero aquí Noah Smith y roon. tienen una versión resumida y aplicada al debate que nos ocupa.

“Tarea” no es un concepto que funcione a un solo nivel, como sabe cualquiera que haya utilizado una app de las de ☑️ — “Comprar naranjas”, “hacer la compra” y “asegurarse de que haya acceso a vitamina C en casa” son todos ellos conceptos susceptibles de ser definidos como “tarea”. Quizás “maximizar el ratio de señal sobre ruido” podría ser una tarea, pero ahora mismo es demasiado general como para ser aprehensible por una IA, tanto de las presentes como de las esperadas en los próximos años. Sencillamente, esa clase de criterio generalizado no está a su alcance.

Pero hay otros que sí. Para mí, lo interesante es identificar cuáles lo empiezan a estar y en qué grado. Porque son esas las tareas que podrían ser reemplazadas o mejoradas, ayudándonos a centrarnos en otras de orden menos específico. Entonces, las IA que estamos viendo emerger, aquellas con las que ya podemos interactuar hoy, se volverían complementarias, no competidoras.

Las tareas en las que la IA nos puede ayudar más (y las que menos)

Lo que sigue es una primera exploración en la que pongo a prueba a ChatGPT con respecto a una serie de tareas que forman parte de mi trabajo día a día. Para cada uno doy una evaluación basada en esta exploración de lo que creo que me puede ayudar en los próximos meses o años.

Definir la pregunta y el marco de análisis / bajo; pero no nulo

No hace falta decir que acercarse a ChatGPT para preguntarle “qué problemas son importantes hoy en día en la sociedad: ¿hacia dónde debo mirar?” carece de todo sentido. Al menos por ahora ese espacio nos pertenece a los humanos. Pero una vez tenemos el foco puesto en un área determinada, la interacción empieza a ser sorprendentemente útil. En la definición de preguntas he encontrado que nunca deja de ser superficial, pero se vuelve menos a más específica es la cuestión planteada.

Por ejemplo: si le preguntas cómo aproximar la cuestión de la pobreza en países ricos te devuelve un par de párrafos bastante genéricos llenos de lugares comunes.

Ahora bien: lo coherente, equilibrado y por tanto completo del resultado es remarcable. No es una respuesta poco sofisticada para un ámbito iniciático (digamos, un estudiante de secundaria).

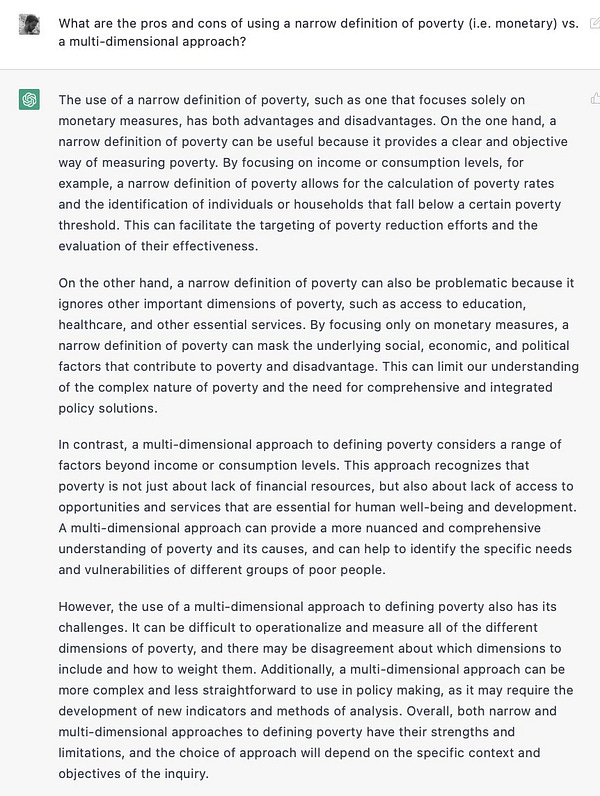

Si estrechamos la cuestión, enfocándola en uno de los debates centrales sobre el problema de la pobreza en la disciplina económica hoy en día, esas cualidades se vuelven algo más nítidas.

Esto ya empieza a parecerse a algo que, previo repaso humano para corregir y asegurar lo afirmado (véase siguiente tarea), podría publicarse en un blog o en un medio no especializado. Es incluso superior en su completitud y matiz a lo que te puedes encontrar en algunas tertulias de radio o televisión. De hecho, creo que esta interacción puede ser una buena manera para enfrentarse al vértigo de la página en blanco. Te da algo de material para empezar a pensar. Y también una proto-lista de cosas a incluir en tu marco de análisis. No es un buen final, pero sí un principio decente.

Encontrar respuestas a preguntas / nulo (y peligroso) como check definitivo, medio-alto como sistema de exploración

Si tuviera que destacar ahora un problema central de los modelos tipo GPT-3 es que son bastante malos distinguiendo los hechos de la falsedad y al mismo tiempo transmiten certeza. Son bullshitters.

No entender esto fue un fallo central de Meta en el lanzamiento de Galactica, una idea prometedora (¡un modelo para ayudar a la creación científica!) pero presentada sin las cautelas necesarias. Que ahora se resumen en que es imprescindible un check humano para validar no sólo la relevancia, sino también la precisión y veracidad de todo lo que sale de estos modelos. Pero, una vez se acepta eso, mi experiencia está siendo bastante positiva e interesante con ChatGPT.

Respuestas existentes a preguntas concretas / incompletas y necesitando check humano, pero útiles

La primera tarea de este tipo con la que experimenté fue un clásico de la investigación científica, que también debería serlo en el debate público o en el trabajo periodístico: una revisión de la literatura; es decir, un repaso a la evidencia existente.

Hace poco publicamos en EsadeEcPol la primera evaluación específica sobre el efecto en el consumo de bebidas azucaradas de la subida del IVA aplicada en España en 2021. Como es natural, el paper incluye una síntesis de estudios similares, magistralmente recopilada por Javier Martínez Santos y Ángel Martínez Jorge. El primero la sintetizó en esta tabla, que incluye todos los estudios comparables al nuestro por (1) método empleado, (2) tipo de política analizada y (3) efectos medidos.

Si le planteas a ChatGPT la misma tarea, la ejecución es claramente inferior al trabajo realizado por investigadores especializados.

O sea, no es suficiente por sí mismo. Sin embargo, supone un excelente punto de partida porque te da dos estudios relevantes e importantes desde los que un investigador puede empezar a tirar del hilo.

Respuestas existentes a problemas concretos / útiles y extensas, aunque no necesariamente correctas

Otra variante de respuestas que busco con frecuencia es la solución a problemas concretos, del tipo “¿qué método de estimación es mejor para testar esta hipótesis?” o “¿cómo proceso estos datos en R de la manera que quiero procesarlos?” — probando con una serie de preguntas como la última, la respuesta de ChatGPT es inmejorable.

Ahora bien: se mantiene el problema de la verificación. Hasta el punto de que, como me hizo notar Esteban Moro, Stack Overflow (el foro de referencia para que los que usamos código vayamos a encontrar soluciones a este tipo de problemas) ha vetado preventivamente las respuestas generadas con ChatGPT “porque la media de respuestas correctas es demasiado baja”.

Entendiendo la decisión de SO, probablemente la mejor solución para un individuo no sea vetar ChatGPT porque la variable relevante no es “media de respuestas correctas” exactamente sino “tiempo que me lleva llegar a una solución adecuada a mi problema”. La respuesta que uno encuentra en sitios como SO casi nunca es perfecta, sino que uno debe probar y adaptar hasta que afina su código. Lo lógico para mí es (y así lo haré desde ahora) incorporar ChatGPT a un nivel similar a SO y ver si realmente me acorta los tiempos de búsqueda de soluciones apropiadas.

Respuestas creativas a problemas más difusos / incierto, pero interesante

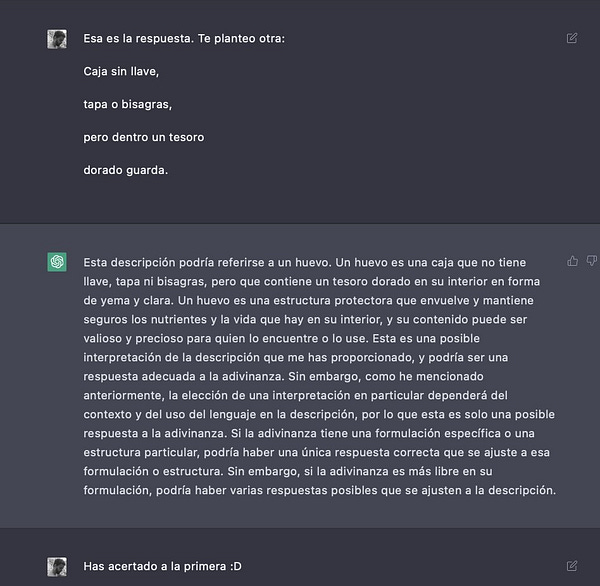

Para llevar al límite a ChatGPT decidí plantearle una adivinanza basada en metáforas. Esto implica un grado de creatividad considerable porque debe salirse de la literalidad de lo que tiene delante. Escogí dos de las que Bilbo y Gollum se plantean cuando se conocen en la cueva de los trasgos en El Hobbit, porque es una escena con la que estoy muy familiarizado (llevo releyéndola de un modo u otro desde que era pequeño).

El primer intento no le fue nada bien. No era capaz de salir de la literalidad; se puso en modo overthink; y le acabó costando ocho iteraciones dar con la respuesta.

Pero después le planteé la segunda adivinanza y… a la primera.

Pero lo que más me llamó la atención no fue su capacidad para acertar o no, sino el tono con el que planteaba sus respuestas. Así que le dije…

Y esto me sirve tanto para volver al punto inicial de este apartado como para pasar al siguiente. Vuelvo al inicial para remarcar que ChatGPT es capaz de transmitir incertidumbre sobre las respuestas que plantea, lo cual ya es un avance considerable en el problema inicial de incapacidad de distinguir hechos de ficción (aunque insuficiente: por eso se está trabajando en detectores de calidad). Le hace menos bullshitter. Además, y con esto pasamos al siguiente, es capaz de relacionar conceptos no inmediatamente vinculados entre sí con una agilidad y sofisticación considerable.

Relacionando conceptos entre sí / medio; estimulante

La remezcla del conocimiento existente es una dimensión clave de la creación de nueva información relevante. Viajar de las adivinanzas de un libro de fantasía de la primera mitad del siglo XX hasta la filosofía de la ciencia de Karl Popper es una buena prueba de uso de este tipo de tarea. Aquí va otra, en la que le planteé a ChatGPT una premisa paradójica sobre la política española. Esencialmente, vi si podía alimentar de un análisis exploratorio y básico pero relevante a un periodista como Borja Ventura, que justo me preguntó por esta cuestión para completar este artículo. La respuesta de la IA no compite con la que le di a Borja en su día, pero haberla tenido desde antes me habría ayudado a maximizar el ratio señal/ruido (recuerdo que tuve que reformularla varias veces y aún así me pareció demasiado extensa y prolija).

Luego Álvaro Millán vino a señalar que dónde estaba una de las teorías clásicas para explicar el comportamiento de los votantes. Se lo planteé a ChatGPT y nada mal:

Siendo además que yo no cité a Downs en mi respuesta original a Borja, debo concluir que el óptimo para el periodista habría sido en este caso ir a Twitter y permitir la interacción de un grupo de usuarios informados con la IA para cimentar la respuesta :)

Reformulación de información / alto; creo que ya no viviré sin él

He dejado para el final la tarea más sencilla para esta IA, y también en la que para mí ahora brilla más: coger contenido que ya existe y mejorar su presentación. Aquí no le trasladamos a la IA el problema de veracidad o precisión; eso depende de nosotros. Solo le pedimos que por favor mejore la accesibilidad de la señal. Esto hizo ChatGPT con el párrafo introductorio de este artículo.

La audiencia de El País tuvo a bien leer mucho, mucho este artículo, algo que les agradezco enormemente. En una pieza como ésta, que entra en un asunto de máxima actualidad e interés ciudadano con una aproximación compleja, el párrafo de apertura es crucial: ahí resumes la información esencial que contarás después, te aseguras la implicación y continuidad de la lectura, y fijas tu mensaje. Pues a un 75% de mi audiencia de Twitter le pareció que la IA hacía mejor este trabajo que yo. Y a mí también, la verdad.

En ese mismo momento probé la reformulación del resumen ejecutivo del paper sobre el IVA a las bebidas azucaradas, para un resultado más que aceptable aunque menos nítido, demostrando que ChatGPT necesita instrucciones precisas para entender qué es señal y qué no de acuerdo con el criterio humano.

De hecho, aquí va una confesión: la anterior entrega de esta newsletter fue un experimento en esta misma dirección que planteé para revelar en esta entrega. Cogí una columna que escribí en abril de 2020 sobre la aproximación del gobierno chino a la pandemia, le pedí a ChatGPT que me la reformulara párrafo a párrafo, y usé partes de ese texto posteriormente editado por mí para completar el conjunto de la pieza. Al final, mis horas de trabajo no fueron notablemente menores, y la cantidad de ideas añadidas en el texto de la newsletter en contraste con la columna original de hace más de dos años es muy considerable. El rol de ChatGPT no fue tanto ahorrarme tiempo de escritura como facilitarme el inicio de un proceso que se me ocurrió sobre la marcha en Twitter a partir de la reformulación de una idea que ya tenía en su día y ahora, a la luz de nuevos acontecimientos, merecía la pena recuperar para ampliar.

Autocompletado, exploración, edición y remezcla

Decían Noah Smith y roon en el post que citaba más arriba que para ellos las IA generativas como ChatGPT funcionarán complementando tareas creativas a modo de “autocompletado para todo”. Pero después de toda esta experimentación para mí el potencial llega a la exploración, edición y remezcla de información previa/posterior verificación por parte de sus usuarios.

El criterio último de relevancia, de separar la señal del ruido, seguirá siendo humano. Pero el potencial para mejorar en ello que ofrecen estas herramientas me parece, al menos, digno de atención y respeto.

Yo tengo la duda de a quién pertenece, en términos de derechos de autor, parte de los textos generados por chatgpt. Me refiero más concretamente a usarlo como herramienta de reformulación de información, como por ejemplo para un texto científico, en inglés, con el fin de clarificar el mensaje.

si los mejores puestos y cargos son para la gente MAS inteligente, viendo como va el mundo, se echa uno a temblar con la inteligencia artificial, por que puede ser que sea MAS inteligente todavia. un saludo